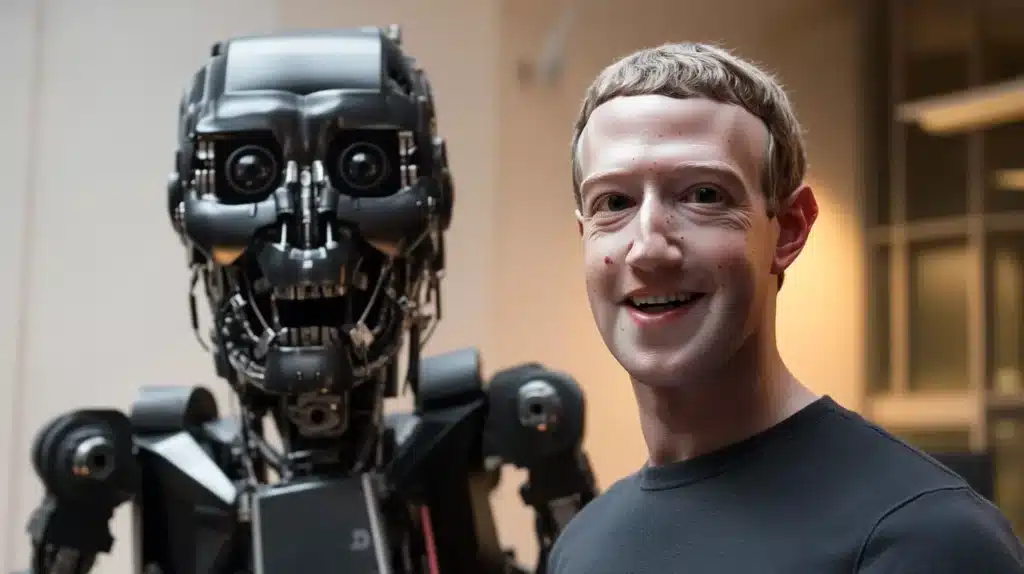

A Nova Abordagem da Meta em Relação à Inteligência Artificial Geral

O CEO da Meta, Mark Zuckerberg, se comprometeu a tornar a inteligência artificial geral (AGI) — que pode ser definida como uma IA capaz de realizar qualquer tarefa que um humano possa — disponível para todos em algum momento futuro. No entanto, em um novo documento de política, a Meta sugere que existem determinados cenários nos quais pode optar por não liberar um sistema de IA altamente capacitado que foi desenvolvido internamente.

O documento, que a Meta intitula como Frontier AI Framework, identifica dois tipos de sistemas de IA que a empresa considera de alto risco: os sistemas de “alto risco” e os de “risco crítico”.

Classificações de Risco da Meta

Segundo a classificação da Meta, tanto os sistemas de “alto risco” quanto os de “risco crítico” podem ser utilizados para auxiliar em cibersegurança, ataques químicos e biológicos. A diferença entre eles é que os sistemas de “risco crítico” podem resultar em um “resultado catastrófico que não pode ser mitigado no contexto de implantação proposto.” Por outro lado, os sistemas de alto risco podem facilitar um ataque, mas não de forma tão confiável quanto os sistemas de risco crítico.

Exemplos de Ataques Potenciais

Mas que tipos de ataques estamos discutindo aqui? A Meta fornece alguns exemplos, como a “comprometimento automatizado de ponta a ponta de um ambiente corporativo protegido pelas melhores práticas” e a “proliferação de armas biológicas de alto impacto.” A lista de possíveis catástrofes mencionadas no documento da Meta não é exaustiva, mas inclui aquelas que a empresa considera “as mais urgentes” e plausíveis de surgir como resultado direto da liberação de um poderoso sistema de IA.

Surpreendentemente, conforme o documento, a Meta classifica o risco do sistema não com base em testes empíricos, mas a partir da contribuição de pesquisadores internos e externos, que são revisados por “decisores de nível superior.” A razão? A Meta afirma que não acredita que a ciência de avaliação seja “suficientemente robusta para fornecer métricas quantitativas definitivas” para determinar a perigosidade de um sistema.

Medidas de Mitigação e Avaliação de Risco

Se a Meta determinar que um sistema apresenta alto risco, a empresa afirma que limitará o acesso ao sistema internamente e não o liberará até implementar medidas de mitigação para “reduzir o risco a níveis moderados.” Por outro lado, se um sistema for considerado de risco crítico, a Meta diz que implementará proteções de segurança não especificadas para evitar que o sistema seja exfiltrado e interromperá o desenvolvimento até que o sistema possa ser tornado menos perigoso.

Adaptação ao Cenário de IA Atual

O Frontier AI Framework da Meta, que a empresa diz que evoluirá com o cenário de IA em mudança, parece ser uma resposta às críticas sobre a abordagem “aberta” de desenvolvimento de sistemas da empresa. A Meta adotou uma estratégia de tornar sua tecnologia de IA amplamente disponível — embora não seja de código aberto na definição comum do termo — em contraste com empresas como a OpenAI, que optam por restringir seus sistemas atrás de uma API.

Desafios da Abordagem Aberta da Meta

Para a Meta, a abordagem de liberação aberta tem se mostrado tanto uma bênção quanto uma maldição. A família de modelos de IA da empresa, chamada Llama, já acumulou centenas de milhões de downloads. Porém, o Llama também foi supostamente utilizado por pelo menos um adversário dos EUA para desenvolver um chatbot de defesa.

Comparação com a DeepSeek Chinesa

Ao publicar seu Frontier AI Framework, a Meta também pode estar tentando contrastar sua estratégia de IA aberta com a da empresa chinesa DeepSeek. A DeepSeek também torna seus sistemas amplamente disponíveis, mas sua IA apresenta poucas salvaguardas e pode ser facilmente orientada para gerar saídas tóxicas e prejudiciais.

Conclusão sobre a Abordagem da Meta

“Acreditamos que, ao considerar tanto os benefícios quanto os riscos ao tomar decisões sobre como desenvolver e implantar IA avançada,” escreve a Meta no documento, “é possível entregar essa tecnologia à sociedade de uma forma que preserve os benefícios dessa tecnologia para a sociedade enquanto mantém um nível apropriado de risco.”

FAQ

O que é inteligência artificial geral (AGI) segundo a Meta?

A inteligência artificial geral, ou AGI, é definida como uma IA que pode realizar qualquer tarefa que um humano possa. O CEO da Meta, Mark Zuckerberg, expressou seu compromisso de tornar a AGI acessível para todos no futuro, mas ressaltou que certos sistemas de IA altamente capacitados podem não ser liberados devido a riscos associados.

Quais são os tipos de sistemas de IA considerados de alto risco pela Meta?

A Meta classifica seus sistemas de IA em duas categorias de alto risco: “alto risco” e “risco crítico”. A diferença principal é que o risco crítico está associado a resultados catastróficos que não podem ser mitigados, enquanto sistemas de alto risco podem facilitar ataques, mas não com a mesma confiabilidade dos de risco crítico.

Quais exemplos de ataques a Meta listou em seu documento?

O documento da Meta menciona possíveis cenários como o “comprometimento automatizado de ponta a ponta de um ambiente corporativo protegido” e a “proliferação de armas biológicas de alto impacto”. Esses exemplos refletem alguns dos riscos mais urgentes que a Meta acredita serem plausíveis devido à liberação de sistemas de IA poderosos.

Como a Meta determina o nível de risco de seus sistemas de IA?

A Meta não utiliza testes empíricos para classificar o risco de seu sistema, mas sim a contribuição de pesquisadores internos e externos, que são revisados por decisores de nível superior. Eles afirmam que a ciência de avaliação atual não é suficiente para fornecer métricas quantitativas definitivas sobre a perigosidade de um sistema.

Quais medidas de mitigação a Meta implementa para sistemas de alto risco?

Se um sistema é identificado como de alto risco, a Meta decidirá limitar o acesso internamente e implementará medidas de mitigação até que o risco seja reduzido a níveis moderados. Isso demonstra o compromisso da empresa em gerenciar os riscos associados à tecnologia de IA.

Como a Meta está se adaptando ao cenário atual de IA?

O Frontier AI Framework da Meta foi desenvolvido em resposta às críticas sobre sua abordagem de desenvolvimento aberto. Essa estratégia visa tornar a tecnologia de IA amplamente disponível, diferindo de outras empresas como a OpenAI, que restringe seus sistemas por meio de uma API.

Qual é o impacto da abordagem aberta de desenvolvimento da Meta?

A abordagem de liberação aberta da Meta tem resultados mistos. Embora os modelos de IA da empresa, como o Llama, tenham sido amplamente baixados, também foram utilizados de forma inadequada, como na criação de um chatbot de defesa por um adversário dos EUA. Isso ressalta a complexidade de gerenciar a acessibilidade em tecnologia avançada.

Como a Meta compara sua abordagem de IA com a da empresa chinesa DeepSeek?

A Meta, ao publicar seu Frontier AI Framework, contrasta sua abordagem com a da DeepSeek, que oferece sistemas de IA amplamente disponíveis, mas com poucas salvaguardas. Isso indica uma preocupação com a segurança e a natureza dos produtos de IA acessíveis no mercado.

Qual é a visão da Meta sobre a entrega de tecnologia de IA à sociedade?

A Meta acredita que, ao considerar tanto os benefícios quanto os riscos no desenvolvimento e implantação de IA avançada, é possível entregar essa tecnologia à sociedade de maneira a preservar seus benefícios enquanto se mantém um nível apropriado de risco. Esse princípio guia sua abordagem estratégica em relação à IA.

Qual é a importância do Frontier AI Framework para a Meta?

O Frontier AI Framework é crucial para a Meta porque aborda tanto as preocupações de segurança quanto a necessidade de inovação na área de IA. Essa estrutura permite que a empresa evolua seu desenvolvimento de IA de acordo com o cenário em mudança e responda a desafios críticos de segurança e ética.

Com informações: TechCrunch

Veja também: